Bir arama motoru kullanıcısı olarak yaptığınız aramalarda karşınıza birçok siteden sonuçlar çıkar. Bu sonuçlardan herhangi birine tıkladığınızda da o web sitesini görmek istersiniz. Yaptığınız tıklama web sitesinin sunucusuna, o sayfayı görmek istediğinizi belirten bir istek şeklinde düşer. Oldukça önemli olan bu istekler doğal olarak sunucuda toplanarak depolanır. Üstelik yapılan bu istekler sadece gerçek kişiler tarafından değil, arama motorlarının botları tarafından siteyi incelemek için de yapılır. Bu da site sahiplerine oldukça iyi bir analiz kaynağı sunar.

Bu yazımda log analizi olarak adlandırdığımız bu analiz sürecini inceleyeceğiz. Sonrasında da Screaming Frog isimli yardımcı bir program ile yaptığımız analizleri hangi anlamlı sonuçlara dönüştürebileceğimize bakacağız.

Log Dosyası Nedir, Nerede Bulunur?

Yukarıda da bahsettiğim şekilde web sitenize yapılan bütün istekler sunucunuzda toplanır. Sunucunuzda bulunan log dosyası sayesinde web sitesi sahipleri bu isteklere erişebilirler. Günlük olarak tutulan bu istekler istenirse belirli bir zaman içerisinde yapılan istekler şeklinde de analiz edilebilir. Ancak sunucunuzda bulunan log dosyası sağlayıcılarınız tarafından aktif olarak kullanılmıyor olabilir. Bu yüzden internet siteniz için yolun başındaysanız sunucu sağlayıcınızla log dosyanızın aktifliği konusunda konuşmakta yarar var.

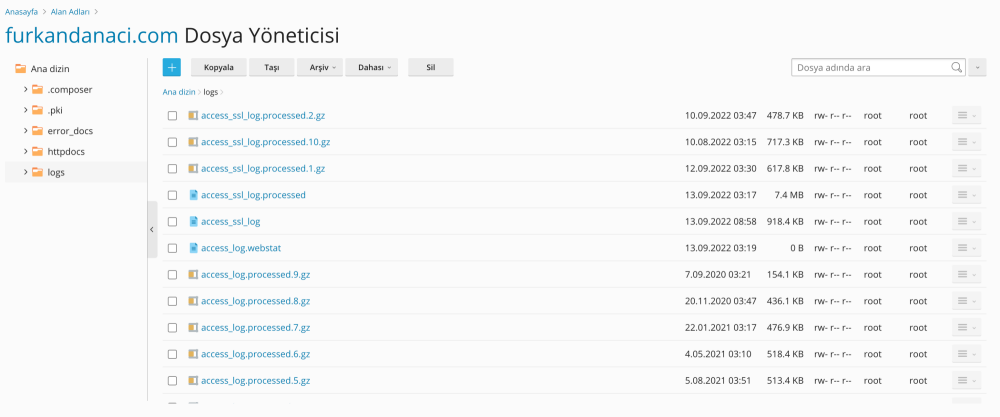

Sitenizin log dosyalarına erişmek için FTP ya da cPanel kullanabilirsiniz. Genellikle sunucu sağlayıcısı üzerinden cPanel erişimi sağlayarak log dosyalarına erişmek daha kolaydır. Dosya yöneticisi içerisinde bulunan “logs” dosyası bu kayıtlara ulaşabilmenizi sağlar. Eriştiğiniz kayıtlar sizin için anlamsız olabilir ancak örnek bir log dosyası içinde sırası ile aşağıdaki bilgiler bulunur:

- İstek gönderenin IP adresi

- İstek yapılan zaman

- Yapılan isteğin türü

- Yapılan isteğe karşılık sunucunun verdiği yanıtın türü

- Yapılan isteği gönderen kaynağın kimliği

- İstek yapılan sayfa bilgisi

- İstek yapılan adres bilgisi

Log dosyaları farklı formatlarda olsa da genel olarak yukarıdaki bilgileri elde etmenizi sağlar. Bu bilgiler tek başına bir anlam ifade etmiyor olabilir. Ancak yapılacak analizler sayesinde web siteniz için son derece faydalı değişiklikler yapabilirsiniz. Bunun için doğal olarak nasıl analiz yapılacağını öğrenmek gerekiyor.

Log Analizi Nedir?

Log analizi, kullanıcılar ve botlar tarafından yapılan istekleri analiz ettiğimiz ve buna göre web sitemizde yapılacak değişiklikleri tespit ettiğimiz bir yöntem. Kullanıcılar tarafından yapılan istekler haricinde arama motoru botları tarafından yapılan istekler bizim için daha önemlidir. Çünkü bu botların gönderdiği istekler sayesinde web sitemizin nasıl tarandığını ve süreçte oluşan teknik hataları görebiliriz. Böylece kullanıcı isteklerine bakmadan da kullanıcı isteklerini derin bir şekilde analiz edebiliriz.

Yapılacak analizler sonucunda elde edebileceklerimizden bazılarını aşağıdaki gibi sıralayabilirim:

- Hangi sayfaların taranmadığını tespit etme

- Arama motorları taramalarında ortaya çıkan hata kodlarını tespit etme

- Web sitenize büyük ölçüde etki edecek tarama eksikliklerini tespit etme

- Arama motorlarının hangi sayfalara önem verdiğini tespit etme

- Tarama bütçesinin harcandığı ancak gerekli olmayan yerleri tespit etme

Elde edilebilecekler bu kadar fazlayken daha fazlasını da öğrenebileceğiniz yanılgısına düşmeyin. Log analizi ya da direkt log dosyanızdan coğrafi verilerden tutun, render süreleri gibi bazı teknik konularda bilgiler elde edemezsiniz.

Tarama Bütçesi Hakkında

Bu kısımda sonraki adıma geçmeden yukarıda bahsettiğim tarama bütçesi kavramına bir parantez açmak istiyorum. Benim gibi SEO uzmanları, web sitelerinin tarama bütçelerine oldukça dikkat eder. Çünkü tarama bütçesi Google botların web sitenizi taramak için sitenizde yer alan sayfalarda geçirdiği zamanı ifade etmektedir.

Web sitenizde yapılan tarama işlemi sonucu sahip olduğunuz sayfalar dizine eklenir. Ancak sayfalarınızın yüklenmesi uzun sürüyor ve çok fazla değersiz sayfa bulunuyorsa Google botlar sitenizi taramayı bırakırlar. Anlayacağınız sitenizin SEO durumu bu taramaları doğrudan etkiler. Bu yüzden tarama bütçesine oldukça önem verilmelidir.

Google için 404 sayfaları, yinelenmiş içeriklere sahip sayfalar ve spam içerikli sayfalar gibi düşük kalitedeki sayfaların taranması ve dizine eklemesi olumsuzdur. Çünkü bu sayfaların taranması için harcanan tarama bütçesi sonucu önemli sayfalarınızın hepsi dizine eklenmeyebilir. Log analizi sonucunda bu sayfaları tespit ederek tarama bütçenizi daha sağlıklı bir şekilde kullanabilirsiniz.

Screaming Frog ile Log Analizi Nasıl Yapılır?

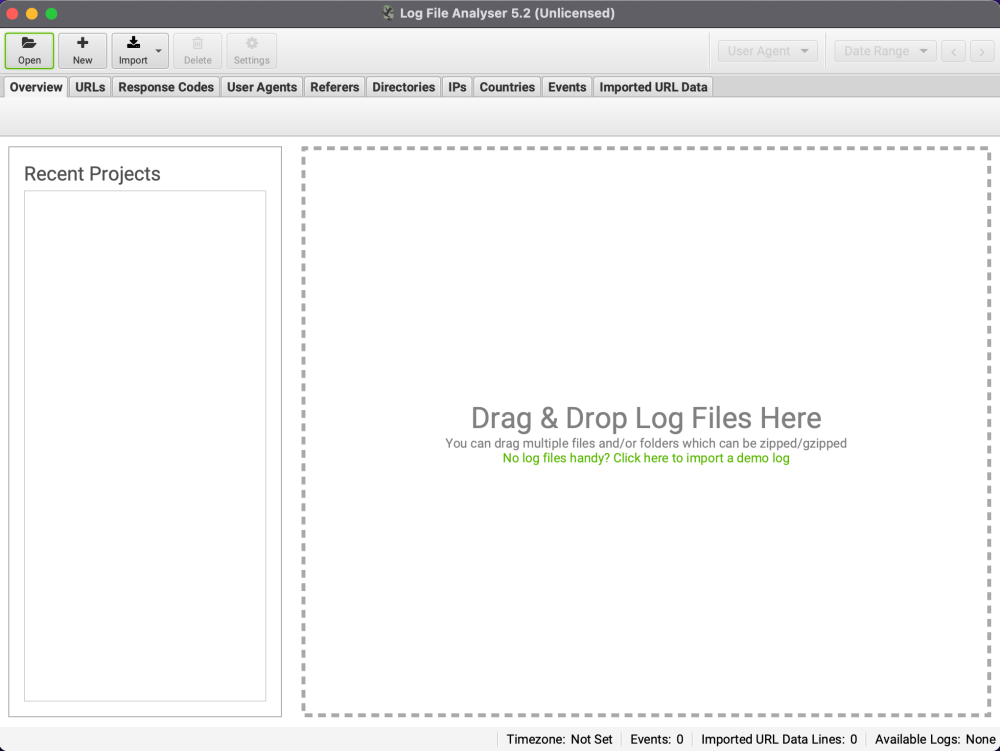

Sahip olduğunuz log dosyalarındaki anlamsız veriler bütününü anlamlı bir şekilde görebilmenizi sağlayacak birçok program bulunuyor. Bunlardan benim de kullandığım bir tanesi olan Screaming Frog, oldukça kullanışlı bir log analiz programıdır. Çünkü program içinde sahip olduğunuz log dosyalarını birçok farklı açılardan analiz edebiliyorsunuz. Bu kısımda da Screaming Frog yardımıyla log dosyalarınızı hangi açılardan analiz edebilirsiniz ona bakacağız.

[box type=”info” align=”” class=”” width=””]SEO Log File Analyser programını buradan ulaşabilirsiniz.[/box]

Taranan Linklerin Tespit Edilmesi

Sitenizde bulunan linklerin hepsini toplayan ve analiz eden birçok araç bulunuyor. Ancak bu araçlardan neredeyse hiçbiri hangi linklerin arama motorları tarafından istendiğini göstermiyor. Log dosyalarının analizi temel olarak hangi linklerin arama botları tarafından tarandığına dayanır. Bunun için de Screaming Frog kullanılabilir.

Log dosyası analiz arayüzüne yüklediğiniz dosyalarda bulunan linkler otomatik olarak taranır. “Linkler” kısmında hangilerinin botlar tarafından tarandığını görebilirsiniz. Ekstra olarak bu kısımda tüm botlar yerine Google botlar şeklinde filtrelemeler de yapabilirsiniz. Aynı yerden hatalı ve dizine eklenmemiş linkleri tespit etmek de mümkündür.

Linkler kısmının yararlarından birisi de yukarıda bahsettiğim tarama bütçesine zararlı düşük değerdeki linkleri tespit etmektir. Alfabetik olarak sıralanan linkler, tekrarlayan linkleri ve yanlış bağlantılardan kaynaklı uzun linkleri kolayca görebilmenizi sağlar. Tarama bütçenizi doğru bir şekilde yönetmek için Screaming Frog üzerinde izleyebileceğiniz tek yöntem bu değildir.

Taranma Sıklığı

Googlebot’un sayfalarınızı ne sıklıkla taradığı, sayfadaki içeriklerin değişmesi gibi farklı faktörlere bağlıdır. En çok taranan linkleriniz en önemli linkleriniz olmayabilir. Böyle durumlarda altında yatan sebepleri görebilmek için birçok seçeneğiniz bulunur. Linkler kısmında bulunan linklerinizi gerçekleşen olaylar sayısına göre sıralamak bunlardan birisidir. Farklı botlar için farklı sayımlar bulunur ve bu sayımları filtreleyerek görebilirsiniz.

Listeyi inceleyerek hangi linklerin Google tarafından boş yere fazla taramaya maruz kaldığını inceleyebilirsiniz. Böylece site yapınız, iç linkleriniz ve site hiyerarşisi konularındaki eksiklikleri de daha temiz bir şekilde fark etmek de mümkün.

Taranma sıklığını bu tür eksikliklerin farkına varmak için site dizinleriniz ve içerik türleriniz gibi seçeneklerde de kontrol edin. Bu durum yine Google’ın tarama sırasındaki harcadığı zamana ve doğal olarak tarama bütçenize etki edecek çıkarım yapmanızı sağlayacaktır.

Kırık Linkler ve Sunucu Hataları

Screaming Frog arayüzünde bulunan “Response Code” yani yanıt kodları sekmesinde arama motorlarının yaptıkları taramalar sonucu karşılaştıkları yanıt kodlarını görebilirsiniz. Client Error (4xx) olarak filtreleme seçeneği belirlediğinizde bütün bozuk bağlantılar ve 4xx şeklindeki sunucu hataları sıralanır.

Çıkan sonuçları taranma sıklığına göre sıralayarak en önemli linklerinizden bu tür hatalar verenleri görebilir ve müdahale edebilirsiniz. Bu kısımda özellikle ayarladığınız filtre kısmının yanında bulunan “Last Response” kutucuğunu işaretlemeniz gerekli. Böylece son taramalarda hata veren linkler görüntülenebilir.

Bu bölümde ek olarak yine filtre üzerinden “Redirection” kısmını seçerek 3xx hatalarına da göz atabilirsiniz. 3xx hata kodları başarısız yönlendirmeleri ifade eder. Sadece 304 hata kodunda herhangi bir aksiyon almanıza gerek yoktur.

“Directories” kısmından bu hataları alt dizinlerinize göre de görüntüleyebilirsiniz. Bu görüntüleme sitenizin hangi bölümünde daha çok hata aldığınızı anlamanıza yarar. Böylece düzeltme çalışmalarınızda o bölümlere öncelik verebilirsiniz.

IP Sekmesi

Doğrulama durumunu “Spoofed” yani sahte olarak ayarladığınızda “IPs” sekmesinde arama motoru botlarını taklit eden istekleri görebilirsiniz. Bu tür istekleri görüntülemek istemediğiniz istekleri bloklamanıza ve siteniz için gereksiz kaynak harcanmamasına sebep olur.

Doğrulama durumunu “Verified” olarak ayarladığınızda ise gerçekten arama botlarının gönderdiği istekleri görebilirsiniz. Bu ayar, özellikle yerel ayarlı sayfalar ve ülkelere göre farklı içerikler sunan web sitelerini analiz etmede faydalıdır. Buradaki IP analizi ile Google’ın içeriklerinize hangi konumlardan eriştiğini görebilir buna göre performans değerlendirmesi yapabilirsiniz.

Büyük ve Yavaş Sayfalar

Tarama bütçeleri kısmında büyük ve yavaş sayfaların öneminden bahsettim. Büyük dosyaların yanıt süreleri ve yavaş açılan sayfalarda harcanan süreler tarama bütçeleri için oldukça tüketici etkiye sahip. Ancak Screaming Frog bu sayfaların tespit edilerek, tarama bütçesinin doğru bir şekilde kullanılabilmesine yardımcı oluyor.

“URLs” bölümündeki linklerde “Avarage Bytes” seçeneğine göre sıralama yaparak büyük sayfalarınızı görebilirsiniz. Burada ortalama byte büyüklüğüne göre büyük sayfalarınızı optimize etmek gerekir. “Avarage Response Time” seçeneğine göre de optimizasyon yapmanız gereken yavaş ve sorunlu sayfalarınızı belirleyebilirsiniz.

Sayfa bazında düşündüğümüzde Screaming Fog, hiçbir linkle ulaşılamayan yetim sayfaları da görebilmenizi sağlar. Programın SEO Spider aracıyla yapacağınız tarama verilerini “Imported URL Data” kısmına yükleyin. Bundan sonra URLs kısmındaki filtre seçeneklerinde “Not In URL Data” seçeneği size yetim sayfalarınızı gösterecektir. Bazılarının yanlış bağlantılar ya da yeniden yönlendirme yapan eski linkler olabileceğini de unutmayın.

Sonuç

Benim gibi SEO uzmanlarının log analizi konusuna özellikle dikkat ettiğini yukarıda da söylemiştim. Çünkü log analizi sonucunda yapacağınız bütün optimizasyonlar SEO konusunda site içi ve teknik SEO anlamında size avantaj sağlar. Ancak arama motoru optimizasyonu için yapılan log analizleri tek seferlik değil, aralıklı olarak yapılmalıdır. Böylece yaptığınız aksiyonların sonuçlarını görebilir ve yeni aksiyonlarınızın ne yönde olabileceğini saptayabilirsiniz.